以下の書籍

を中心に時系列解析を勉強していきます。

前回

3. ARMA過程

3.3 AR過程

ある時点の値にそれ以前の値を盛り込む方法として自己回帰()過程がある。

次

過程は

と定義され、と書く。確率的変動は

過程と同様に攪乱項(

)がもたらす。定常性の有無はパラメータの値に依存して決まる。

次

過程は

と書ける。

一般の次

過程について、ホワイトノイズ

の期待値が

であることに注意すると

である。この過程が弱定常であると仮定すると、であるから、

となる*1。

また分散は

である。この過程が弱定常であると仮定すると、であるから

すなわち、

である。

さらにラグに対して自己共分散

を計算する。

過程の方程式

に対して両辺とそれぞれとの共分散を取ることで

であり、これをまとめることで

を得る。このように自己共分散は上記の連立方程式の解として得られる。この連立方程式の両辺を

で割って自己相関係数にしたものを

-

方程式と呼ぶ。

なお定常性の有無については、以下の方程式(方程式と呼ぶ。)

の解の絶対値がすべてよりも大きいことと定常性をもつことが同値であることが知られている。また同方程式が共役な複素数

をもつとき、この過程は周期が

となる循環成分をもつことも知られている。

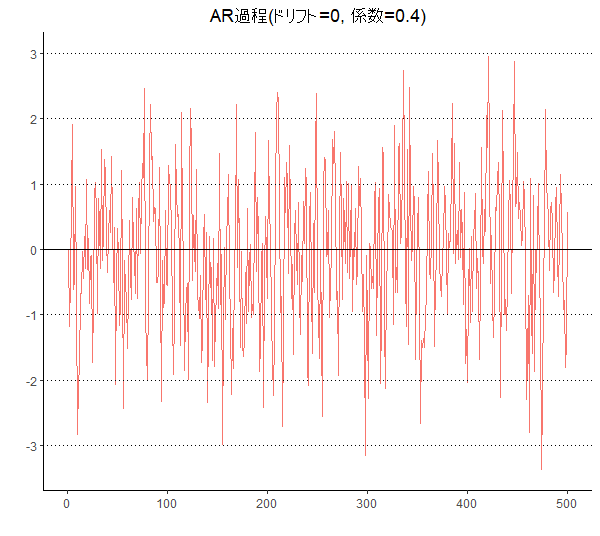

###############

### AR過程 ###

###############

init_var <- 0

param_ar <- 0.4

vc_white_noise <- rnorm(500,0,1)

vc_ar <- c(init_var)

for(i in 2:length(vc_white_noise)){

vc_ar <- c(vc_ar,vc_white_noise[i] + param_ar * vc_ar[i-1])

}

df_ar <- data.frame(date = 1:length(vc_white_noise),

AR = vc_ar)

# 図示

g <- ggplot(df_ar,aes(x = date, y = AR, color = "blue")) + geom_line()

g <- g + theme_classic()

g <- g + ggtitle(paste0("AR過程(ドリフト=",init_var,", 係数=",param_ar,")"))

g <- g + labs(x ="",y="")

g <- g+ theme(plot.title = element_text(hjust = 0.5),legend.position = "none",

legend.title=element_text(size = 7),

legend.text=element_text(size = 7))

g <- g + geom_hline(yintercept = 0, linetype = 1)

g <- g + geom_hline(yintercept = -3, linetype = 3) +

geom_hline(yintercept = -2, linetype = 3) +

geom_hline(yintercept = -1, linetype = 3) +

geom_hline(yintercept = 1, linetype = 3) +

geom_hline(yintercept = 2, linetype = 3) +

geom_hline(yintercept = 3, linetype = 3)

g <- g + scale_y_continuous(labels = seq(-3,3,1),breaks = seq(-3,3,1))

plot(g)

|

3.4 ARMA過程

自己回帰項と移動平均項を両方とも含んだ過程を考えることができ、これを自己回帰移動平均()過程という。

次

過程は

と定義される。と書く。

過程および

過程の双方の性質を有し、どちらが強いかで構築した

モデルの性質が決まる。

ホワイトノイズの期待値がであることに注意すると

を得る。

過程は

過程と

過程それぞれがもつ特徴を共にもつことも推察できるように、定常とは限らないうえ、任意のMA過程についてある期待値および自己相関構造(自己共分散および自己相関係数)を指定してもそれを満たす

過程は複数存在する(一意ではない)ことから、モデリングにあたってはモデル選択が必須であり、そのための基準が論点となる。

定常な過程は以下のような性質を持つ:

定常

(2) 次以降の自己共分散と自己相関は

が従う

過程の

部分と同一の係数をもつ以下の

次差分方程式に従う

(3) 過程の自己相関は指数的に減衰する。

3.5. ARMA過程の定常性と反転可能性

過程は常に定常であるものの、任意の

過程に対して同一の期待値と自己相関構造を持つ異なる

過程が複数存在するという問題がある。すなわち期待値や自己相関といった母数を与えても一意に定まらない。そこで自己相関をモデル化するのにどのようなモデルを使うべきかが定かではない。

そこで自己相関をモデル化するに当たり適当な過程を定めるための基準として反転可能性という概念を導入する。

3.5.1 AR過程の定常性

過程が定常になるのは、

過程と同一の係数をもつ差分方程式が安定的になる場合である。

より具体的に述べよう。過程

の定常条件は、

のすべての解の絶対値がよりも大きいことである。この式を

特性方程式という。

3.5.2 MA過程の定常性

前述したように、過程は常に定常ではあるものの任意の

過程に対して同一の期待値と自己相関構造を持つ異なる

過程が複数存在する。

3.6 ARMA過程の定常性:反転可能性

過程の定常性についてはAR特性方程式が安定的であることが必要だとすでに述べたが、それが

過程にそのまま援用できる。他方で

過程が定常であることはその過程が

過程に書き直すことができることと同値であることが知られている。

たとえば1次過程

を考える。逐次的に代入していくことで

が得られる。ここでAR過程が定常ならばであるから、

となる。したがって定常な1次AR過程

について

と書き直すことが可能である。この反転可能性が過程の定常性についての別の表現となる。

過程の選択に当たっても「反転可能性」に注目することとなる。すなわち

過程が

過程に書き直せるときにその

過程は反転可能であると呼ばれる。同一の期待値と自己相関構造をもつ

過程のうち反転可能性のあるものは1つしかないことが知られている。ではある

過程が与えられたときにそれが反転可能性を持つか否かをどう判定すべきかというと、その過程の係数を用いた方程式

の解について調べればよい。この特性方程式についてすべての解の絶対値が1よりも大きいならば、その

過程は反転可能である。

さて以上を踏まえると、過程についても定常性を判定する手段を考えることができる。

過程はつねに定常である。定常過程の和は定常過程になる*2から、ARMA過程はAR過程部分のAR特性方程式を考えればよいことになる。